Bellman equation 贝尔曼方程

阅读量:

#发芽

是 [[ Dynamic Programming 动态规划|动态规划 ]] 达到最优的必要条件,也可称作动态规划方程(Dynamic Programming Equation)

缘由

在追求最优结果的条件下,下一个最优状态总是由当前的最优状态发展而来,因此可以避免重复计算当前的最优状态

说明

假设处于一个 马尔可夫决策过程 中,由于下一个状态总是由上一个状态经历某种变化得到,而经历的变化总是选择奖励最大化的动作,因此在一个最优策略中的子策略也一定是最优的,即最优子结构。

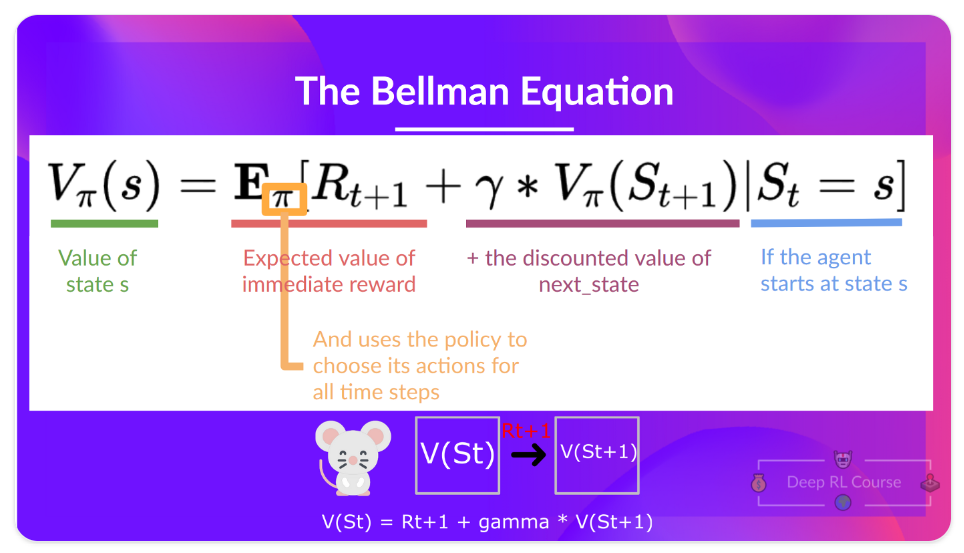

方程如下:

由于假设是处于 马尔可夫决策过程 中,并且每个状态下的动作都会使得预期奖励最大化,因此不存在整体最优不在通过贝尔曼方程找到的状态链上的情况,否则与假设不符。

实例

强化学习

在 基于价值的强化学习方法 中,当前状态的价值等于在当前状态下执行动作后得到的奖励加上折扣后的下一状态的价值

类比

[!note] 记录与该概念类似的概念,属于 how 的部分

对比

[!note] 记录与该概念进行对比的概念,属于 how 的部分

效果

[!note] 记录该概念如何解决实际问题,属于 how good 的部分

备注

- 补充方程

反向链接

Rl value function 价值函数

强化学习中 [[Value-Based Method 基于价值的方法

Value-Based Method]] 所使用的价值函数(Value Function)

到头儿啦~

预览: